首页 >> 综合 > 精选知识 >

跨模式检索的充分对齐和交互

随着社交网络的普及,图像、文本、音频等不同形态的数据在互联网上迅速增长。随后,跨模态检索成为各种应用中的一项基本任务,并近年来受到了极大的关注。跨模态检索的核心思想是学习不同模态(例如,视觉和文本数据)之间的准确且可概括的对齐,以便可以使用来自另一种模态的查询在一种模态中正确检索语义相似的对象。

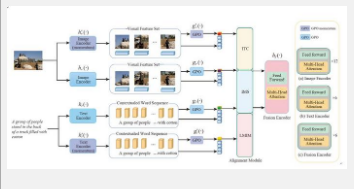

本文提出了一种跨模态检索的新颖框架,旨在对不同模态的聚合特征进行充分的对齐和交互,以有效地弥合模态差距。所提出的框架包含两个关键组件:精心设计的对齐模块和新颖的多模态融合编码器。具体来说,我们利用图像/文本编码器从输入图像/文本中提取一组特征,并维护与图像/文本编码器对应的动量编码器,为模型训练提供丰富的负样本。受到最近特征聚合工作的启发,我们采用了广义池化算子(GPO)的设计来提高全局表示的质量。为了确保模型学习充分对齐的关系,我们引入了一个具有三个目标的对齐模块:图像文本对比学习(ITC)、模态内可分离性(IMS)和局部互信息最大化(LMIM)。ITC鼓励模型分离不匹配的图像-文本对并合并匹配的图像-文本对的嵌入。 IMS使模型能够学习能够使用相同模态区分不同对象的表示,这可以在一定程度上缓解表示退化的问题。 LMIM 鼓励模型最大化全局表示(聚合特征)和局部区域特征(例如图像块或文本标记)之间的互信息,旨在捕获所有区域之间的共享信息,而不是受到某些噪声区域的影响。为了赋予模型探索不同模态之间交互信息的能力,我们在模型末尾加入了多模态融合编码器,以在跨模态对齐后执行不同模态之间的交互。

免责声明:本文由用户上传,与本网站立场无关。财经信息仅供读者参考,并不构成投资建议。投资者据此操作,风险自担。 如有侵权请联系删除!

分享:

最新文章

-

2025年6月20日,——在世界文化遗产地河南洛阳的光影流转之间,2025年新浪微博旅游之夜盛大举行。作为国内首个...浏览全文>>

-

2025年6月20日,——在世界文化遗产地河南洛阳的光影流转之间,2025年新浪微博旅游之夜盛大举行。作为国内首个...浏览全文>>

-

QQ多米试驾线下预约活动为了让更多用户感受QQ多米的独特魅力,我们特别推出了线下试驾预约活动。这不仅是一次...浏览全文>>

-

阜阳长安启源A07以其卓越的性能和豪华配置吸引了众多消费者的目光。作为一款定位高端市场的新能源车型,长安启...浏览全文>>

-

【安徽淮南大众CC新车报价2025款大公开】大众CC作为一款兼具运动感与豪华质感的轿跑车型,一直深受消费者喜爱...浏览全文>>

-

2025款长安猎手K50在安徽淮南地区的最新价格已新鲜出炉,为准备购车的朋友带来全面解析。这款车型以其高性价比...浏览全文>>

-

在安徽滁州购买长安猎手K50时,了解其落地价和省钱技巧至关重要。长安猎手K50是一款实用性强的皮卡车型,适合...浏览全文>>

-

途锐新能源是大众旗下的一款高端插电混动SUV,目前在安徽阜阳地区有售。其官方指导价约为58万元起,但实际成交...浏览全文>>

-

2025款大众CC作为一款兼具运动与豪华的中型轿车,备受关注。目前市场指导价大约在25万至35万元之间,具体价格...浏览全文>>

-

2024款探岳X作为一款备受关注的中型SUV,在市场上以其时尚的设计和出色的性能吸引了众多消费者。根据最新市场...浏览全文>>

大家爱看

频道推荐

站长推荐

- QQ多米试驾线下预约

- 安徽滁州长安猎手K50落地价,买车省钱秘籍

- 淮南大众CC新款价格2025款多少钱?买车攻略一网打尽

- 瑞虎8 PRO试驾,畅享豪华驾乘,体验卓越性能

- 安徽阜阳长安启源A05多少钱 2025款落地价,换代前的购车良机,不容错过

- 保时捷Macan试驾的流程是什么

- 安徽淮南大众ID.3多少钱?购车攻略在此

- 阜阳揽巡落地价,豪华配置超值价来袭

- 安徽池州威然 2024新款价格与配置的完美平衡

- 奇瑞瑞虎9试驾,新手必知的详细步骤

- QQ多米价格,换代前的购车良机,不容错过

- 池州迈腾GTE新款价格2022款多少钱?选车秘籍与优惠全公开

- 岚图追光多少钱 2024款落地价走势,近一个月最低售价25.28万起,性价比凸显

- 天津滨海威然 2024新款价格,最低售价28.98万起,入手正当时

- 蚌埠途昂新款价格2025款多少钱?购车必看

- 坦克400预约试驾全攻略

- 天津滨海ID.7 VIZZION价格,各配置车型售价全揭晓,性价比之王

- 安庆帕萨特最新价格2025款,最低售价12.35万起,入手正当时

- 亳州宝来新款价格2025款多少钱?选车指南与落地价全解析

- 生活家PHEV 2025新款价格,最低售价63.98万起现在该入手吗?